数据去重(Data Deduplication)是一种高效、广泛应用的数据冗余消除技术,它识别并消除系统中的重复数据块,以此缩减数据规模,降低存储开销。由于效果显著,数据去重技术被广泛应用于各类存储系统中。然而,这种方式也带来了严重的碎片化问题:原本逻辑上连续的备份镜像,在去除重复数据块后,其物理存储布局变得高度离散,进而影响后续的访问效率。碎片化问题催生了去重碎片消除的需求。现有的去重碎片消除技术效果不尽人意,存在去重率下降、I/O开销大以及应用场景优先等问题。

在国家自然科学基金委员会(项目号:62472127)等的支持下,哈尔滨工业大学(深圳)夏文教授团队提出了一种名为GCCDF的去重碎片消除技术,以解决现有去重碎片消除技术存在的不足。GCCDF利用碎片整理和垃圾回收的过程的高度相似性,在垃圾回收的过程中顺带做碎片整理,避免了碎片整理额外的数据拷贝开销,实现整体I/O开销比两者单独执行更低的效果。在此基础上,GCCDF又提出基于归属管理的数据块碎片聚类技术和适配容器结构的数据分类整理技术,分别解决了去重数据碎片消除过程中的局部性冲突和数据结构粒度冲突,让碎片整理更高效。

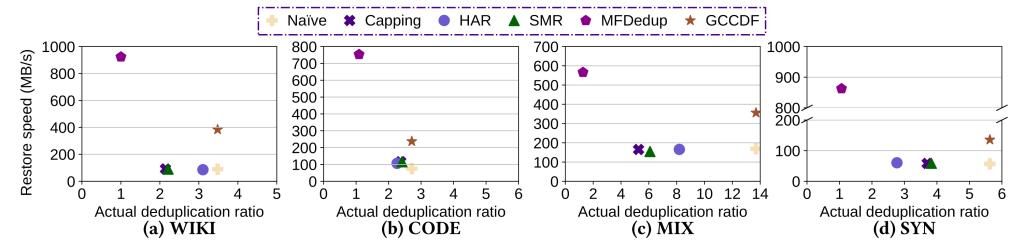

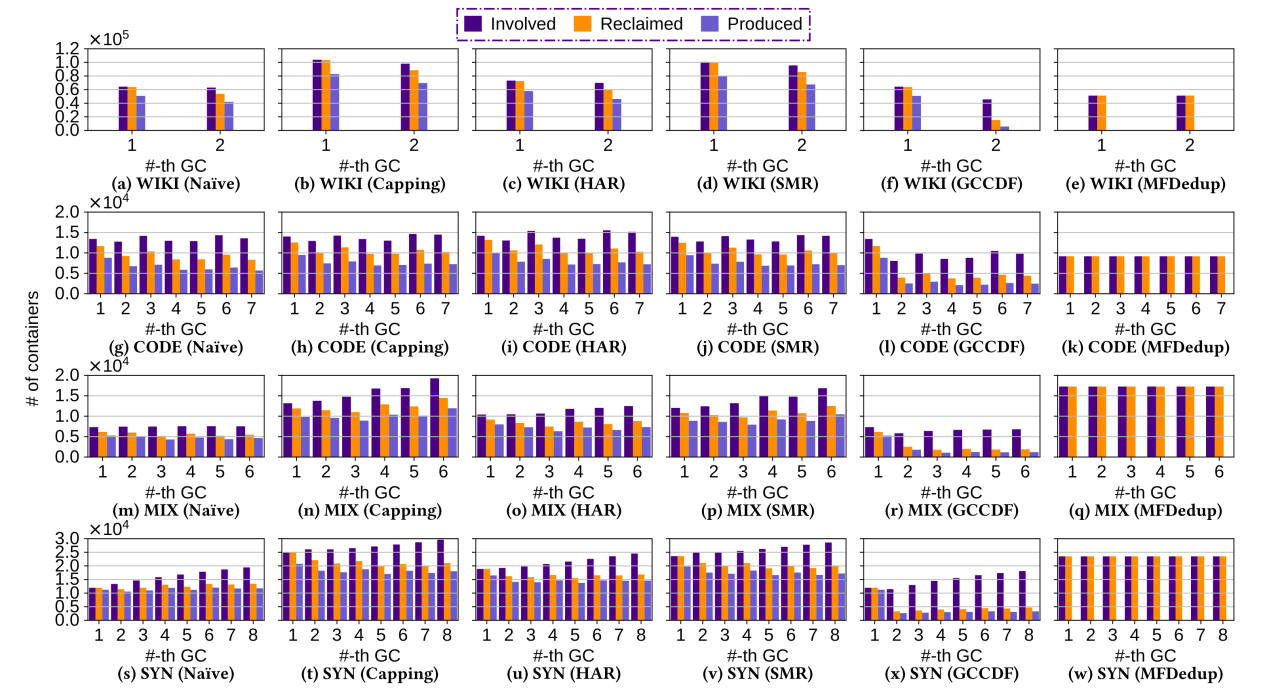

图1所示的恢复吞吐实验和图2所示的迁移容器数量两个实验结果表明,与基准方法相比,GCCDF有效地消除了数据碎片,对恢复吞吐的提升可达3.1倍,且不降低去重率,并且相比于其他方法迁移的容器数量只有约1/3,有效地降低了系统I/O开销。该成果已发表于领域顶级会议Proceedings of the Twentieth European Conference on Computer Systems(EuroSys ’25,EI,中国计算机学会推荐A类国际学术会议,录用率8.17%)。

图1 恢复吞吐测试

图2 迁移容器数量测试

哈尔滨工业大学(深圳)夏文教授团队立足国家战略需求和学术前沿,长期从事存储系统、数据备份、去重压缩、操作系统等领域的研究,近年来在FAST, OSDI, ASPLOS, EuroSys等国际顶级期刊和会议发表论文80余篇,荣获省部级一等奖2项,促进了国家相关计算机领域学科的发展。(审核 夏文)